Il Crawling Budget si può spiegare come il tempo e le risorse che lo spider del motore di ricerca applica al tuo sito web per effettuare il crawl, la scansione dei tuoi contenuti, e siccome è una quantità spesso molto piccola, è necessario fare in modo che sia impiegata nel migliore dei modi.

Un motore di ricerca, come Google, lancia i propri spider sui siti web del globo affinchè effettuino il Crawling per estrapolare nel minor tempo possibile le sue informazioni e siccome di siti web ce ne sono tanti (1,88 miliardi nel 2021) capisci bene che non può perdere troppo tempo con ognuno di essi.

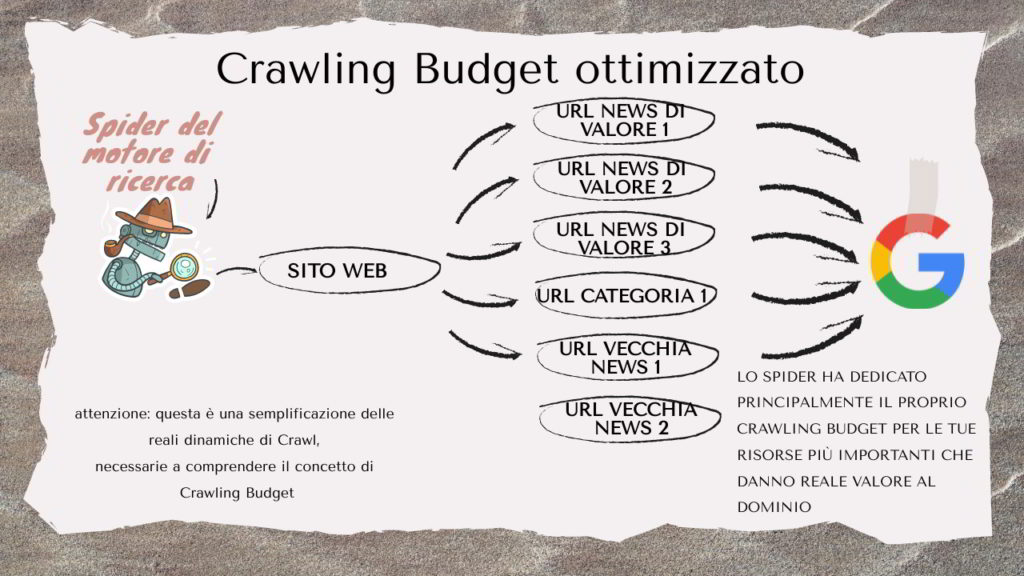

É necessario quindi andare ad ottimizzare il tempo e le risorse che lo spider ti mette a disposizione, per fare in modo di agevolare l’indicizzazione su contenuti e pagine per te più importanti che tengono in piedi la tua strategia digitale e il tuo business.

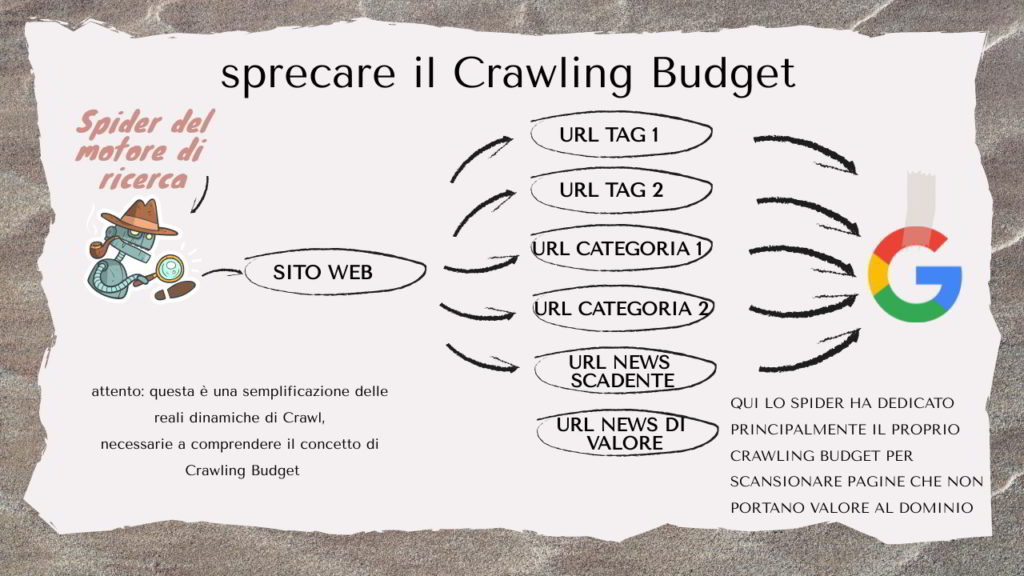

Cosa succede a sprecare il Crawling Budget?

Se lo spider di Google passa sul tuo sito e dedica le proprie risorse su pagine bianche, con pochi contenuti, che danno errore o che sono “in bella vista” ma scarne nei contenuti, il tuo sito web sarà lento nella crescita organica sui motori di ricerca.

Questa lentezza nella crescita si traduce materialmente nella difficoltà di farti trovare in una ricerca e in un posizionamento scarso sui motori di ricerca: se tu fai perdere tempo al Crawler, lui non ti premia e anzi, ti penalizza.

Come si ottimizza il Crawling Budget?

Se non sei un tecnico e/o un SEO Specialist, fai attenzione a seguire con parsimonia la mia guida qui sotto perchè il rischio di fare seri danni alla visibilità del tuo sito web è sempre presente.

L’ottimizzazione del Crawling Budget parte dalla razionalizzazione delle pagine che compongono il sito web, analizzando che cosa è indicizzato in quel momento attraverso la Search Console di Google o il Webmaster Tools di Bing e quindi assorbe risorse di crawling allo spider.

L’attenzione in questa analisi deve essere messa su:

- Pagine che contengono poco contenuto

- Pagine che raggruppano altre pagine, come le news

- Pagine accessibili che restituiscono errore

- Pagine lente ad aprirsi

- Pagine che restituiscono pagina bianca

- Pagine corrette, ma poco inerenti al business

Il taglio o la deindicizzazione dei “rami secchi” è quindi importante per spostare l’attenzione dello spider su pagine e contenuti di reale valore per il business dell’azienda, durante il crawling quando approda sul tuo sito web a rastrellare informazioni.

Ottimizzare il Crawling Budget su WordPress

Quanto sto per indicarti sono delle mosse corrette per ottimizzare il Crawling Budget su WordPress, ma ricorda sempre che ogni sito web è costruito in modo differente usando le features del CMS in modo unico, il che potrebbe quindi rendere errati i miei consigli.

- Pagine dei Tag: il Tag su WordPress è uno strumento utile per raggruppare articoli in maniera orizzontale, perchè articoli di categorie differenti possono avere in comune alcuni elementi. Su WordPress ogni nuovo Tag generato, crea una nuova pagina accessibile sul sito il cui link è presente in tutti gli articoli a cui è associata, quindi lo spider quando passa per scansionare entrerà anche in queste pagine, dedicandogli così una parte del proprio Crawling Budget. Il problema sta nel fatto che molto spesso queste pagine contengono pochi articoli collegati al singolo tag, senza restituire una pagina realmente utile per l’utente e senza nuovi interessanti contenuti per lo Spider del motore di ricerca.

- Pagine delle Categorie: le categorie su WordPress sono tipicamente utilizzare per raggruppare gli articoli in maniera verticale, indicandone quindi un termine che rappresenti la famiglia di cui fa parte assieme ad altre news presenti sul tuo sito web. Anche in questo caso, come con i Tag, WordPress crea una pagina accessibile per ogni categoria creata e il rischio è di trovarsi molte pagine con pochi articoli al proprio interno a cui lo Spider accede dedicando Crawling Budget.

- Pagine non trovate: le pagine con errore 404 che magari hai eliminato nel tempo dal backoffice di WordPress, vanno assolutamente fatte sparire il prima possibile dai vari link presenti sul sito web, o il rischio è di dire allo spider di accedere ad una pagina che non siste più, sprecando ulteriore Crawling Budget che potrebbe usare per i tuoi nuovi articoli appena pubblicati, più interessanti.

- Pagine pesanti: controlla che le pagine del tuo sito web non siano più pesanti di 500Kb, immagini incluse, perchè più una url fa scaricare dati allo spider, più risorse dovrà usare per fare crawling della singola pagina con il risultato che sprecherai il tuo budget. La grandezza dei file delle immagini è tipicamente un motivo per la pensantezza totale della singola pagina, quindi lancia l’occhio a questo importantissimo dettaglio.

La SEO per il Crawling Budget

A cosa serve la SEO? La SEO serve ad ottimizzare i siti web per i motori di ricerca ed il Crawling Budget è uno degli elementi che in una strategia SEO, può fare la differenza: dopotutto creare nuovi contenuti ed agevolare lo Spider affinchè li indicizzi velocemente e ne crei un buon posizionamento per il sito web, è una delle funzioni del Seo Specialist che si avvale di strumenti SEO avanzati per studiare e analizzare i vari siti e muoversi quindi di conseguenza.

Per quanto mi riguarda, per migliorare il Crawling Budget al mio sito locotek.it, ho applicato io stesso una pesante ottimizzazione nel 2021, che aveva il precedentemente il blog su un terzo livello (blog.locotek.it) e prima ancora, nel 2008, il dominio principale era locotek.net, quindi molta storia e molti “problemi” pregressi: oggi, lo vedo dall’analisi delle keyword che faccio quasi quotidianamente, gli spider lavorano molto più concentrati sui contenuti di qualità che scrivo (e che ho scritto in passato), elevando il posizionamento verso nuove keyword che precedentemente non avevo mai considerato.

Ho eliminato molte pagine sul mio sito, ho messo a noindex tutte le pagine dei tag e ne ho eliminati molti, ho richiesto la deindicizzazione di numerose url dalla Search Console di Google e ho anche cambiato il template grafico con uno nuovo che mi ha fatto schizzare i punteggi di velocità a 100/100 su desktop e 100/100 su mobile, quindi mi sento di poter dire di avere oggi un sito molto ottimizzato che sfrutta bene le risorse degli spider e del crawling budget che mi mettono a disposizione.

Si tratta però di una strategia che ho applicato sapendo quello che andavo a fare, tenendo sotto controllo i dati in maniera costante, utilizzando i plugin corretti e i software di keyword research giusti: se anche tu sei intenzionato ad apportare questo tipo di ottimizzazione SEO per il Crawling Budget, fai in modo di avere le idee ben chiare su quello che stai facendo, o contattami.